Rdzenie AI w procesorach i kartach graficznych. Czy to ma jakieś zastosowanie praktyczne?

Producenci sprzętu instalują rdzenie odpowiedzialne za obliczenia AI w kartach graficznych i procesorach. Co z tego wynika i gdzie znaleźć oprogramowanie, które je wykorzysta?

Po co w ogóle nam rdzenie AI, skoro aktualnie większość obliczeń tego typu odbywa się w chmurze? Bo nie każdy chce wysyłać swoje dane na zewnętrzne serwery, bo awaria internetu może przeszkodzić nam w obliczeniach, bo opóźnienia i w końcu - koszty (utrzymanie serwerów do obliczeń AI kosztuje krocie i ich darmowość zapewne wkrótce się skończy).

Generalnie dedykowane jednostki do obliczeń AI mamy już praktycznie wszędzie:

- Tensor (NVIDIA GeForce RTX)

- XDNA/AI cores (AMD Ryzen 7040*/Radeon RX 7000)

- VPU/XMX (Intel Core 14th gen./Intel Arc)

- Neural Engine (Apple M1/M2/M3)

* z wyłączeniem modeli Dragon Range

W przypadku procesorów Intela i AMD trzeba brać pod uwagę, że nowe jednostki odpowiedzialne za AI są instalowane dopiero w AMD Phoenix i Intel Meteor Lake (14. generacja Core). Mieliśmy okazję testować już laptopa z procesorem AMD Phoenix, ale na premierę rdzenie AI można było użyć w zasadzie tylko w jednym celu - generowania efektów tła, czy automatycznego kadrowania przy użyciu wbudowanej kamery. Początki zaiste skromne. Co się zmieniło od tamtej pory?

Wykorzystanie rdzeni AI

Oczywiście niektóre rdzenie AI, jak choćby Tensor NVIDII, są już używane od dawna i to z powodzeniem. Posiadacze kart GeForce RTX używają ich za każdym razem gdy podczas rozgrywki używają technologii skalowania DLSS. W przypadku rdzeni AI w kartach Radeon sytuacja wygląda nieco gorzej i brakuje oprogramowania, które potrafiłoby je wykorzystać. Ostatnie posunięcia AMD pokazują, że wkrótce może się to zmienić, ale na razie... cóż... rdzenie AI są bo są.

Nie da się ukryć, że NVIDIA ma na obecną chwilę lepsze wyniki w wykorzystaniu rdzeni AI, bo po prostu pierwsza zaczęła prace w tym temacie. Rdzenie Tensor można wykorzystać nie tylko w grach, czy podczas transmisji wideo (NVIDIA Broadcast), ale i w takim oprogramowaniu jak Adobe Creative Cloud, Blender, Blackmagic DaVinci Resolve, czy OBS Studio. Zapewniono wsparcie rdzeni AI przy projektowaniu 3D np. za pomocą NVIDIA Omniverse, Adobe Substance, Adobe Painter, czy Unreal Engine.

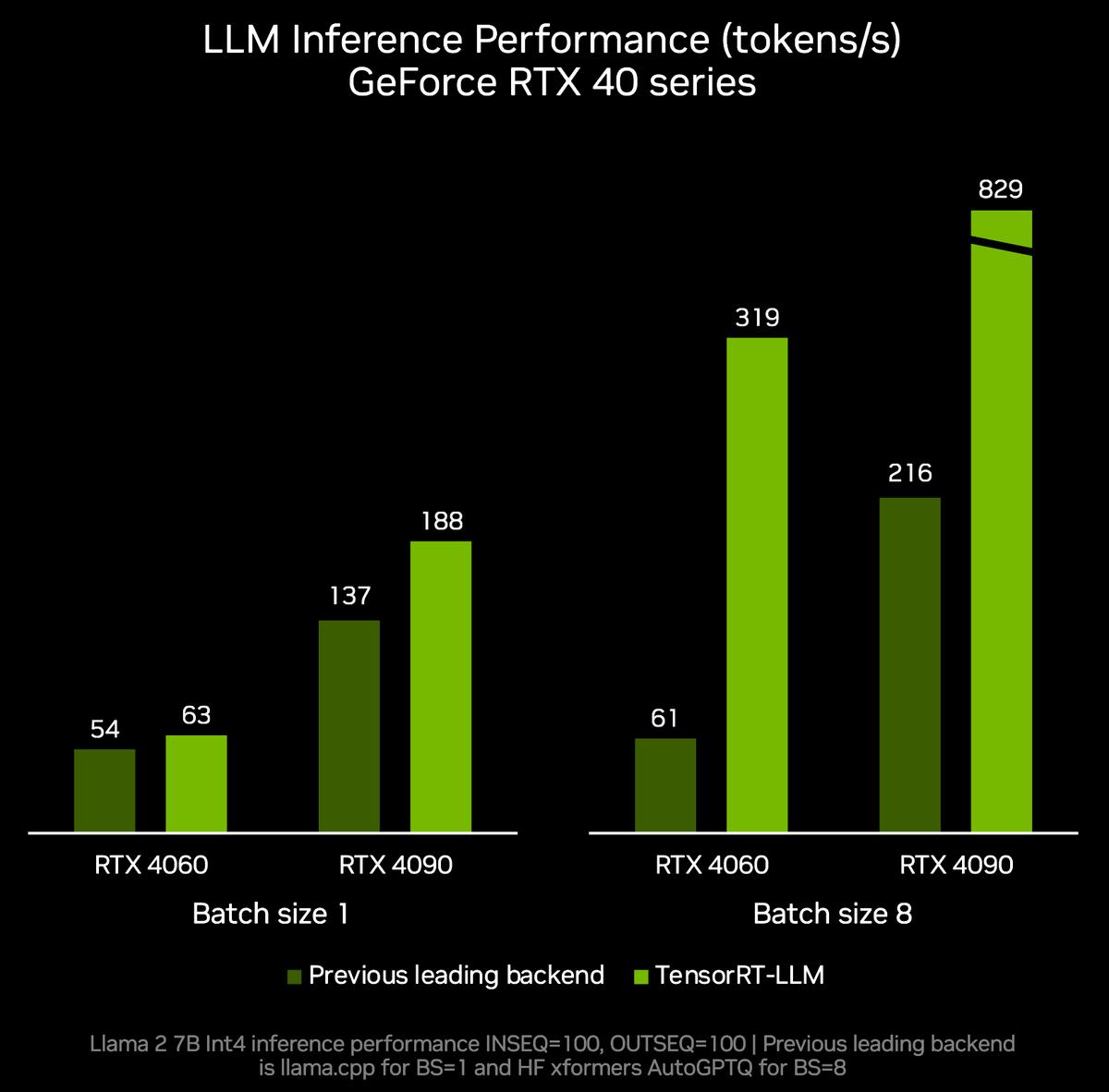

Istotne jest tu również wsparcie systemu operacyjnego, ale i zadbano i o to. Dzięki współpracy z Microsoftem w użyciu wkrótce znajdą się nowe biblioteki TensorRT-LLM, które obsługują dodatkowe algorytmy LLM na kartach graficznych GeForce RTX z serii 30 i 40 z 8 GB pamięci VRAM. Wygląda na to, że posiadacze pierwszej generacji RTX będą musieli obejść się ze smakiem. Nowe biblioteki będą zgodne między innymi z API Chat GPT, a usprawnione biblioteki DirectML znacznie przyśpieszają działanie różnych modeli sieci neuronowych.

Jak widać NVIDIA nie poprzestaje na zarabianiu miliardów dzięki produkcji kart do obliczeń AI, ale i efektywnie działa tak, by rynek oprogramowania nadążał za ich sprzętem, co przynosi wymierne efekty.

Nie można powiedzieć, by w AMD nic się w tej kwestii nie działo. Rozpoczęto instalację drugiego eksaskalarnego superkomputera na świecie o nazwie El Capitan, który będzie oparty o akceleratory AMD Instinct MI300A, które świetnie sprawdzają się w przypadku obliczeń AI. Jeśli jednak chodzi o wykorzystanie rdzeni AI przez zwykłych użytkowników, to wciąż czekamy na odpowiednie rozwiązania programistyczne.

Zobacz inne artykuły dotyczące AI:

Jeśli chodzi o wykorzystanie rdzeni AI w procesorach to... i w tym przypadku wszystko wskazuje na to, że AMD nie będzie tu liderem. Intel od lat rozwija swoją platformę OpenVINO do tworzenia modeli uczenia maszynowego i można postawić orzechy przeciwko diamentom, że będzie się ona świetnie dogadywać z jednostkami NPU (Neural Processing Unit) w procesorach Meteor Lake.

Pomimo ciągłego zalewu newsów dotyczących nowych rozwiązań AI, zwykły Kowalski może zaprząc do roboty praktycznie jedynie rdzenie Tensor w kartach GeForce RTX i prawdopodobnie Neural Engine w procesorach Apple Silicon. Na szersze wykorzystanie rdzeni AI w kartach Radeon, czy też CPU Intela i AMD przyjdzie nam jeszcze poczekać.