Jak Facebook próbuje zapobiegać samobójstwom. Bo próbuje

Z okazji Światowego Dnia Zapobiegania Samobójstwom Facebook opublikował post na blogu, w którym tłumaczy, jak platforma stara się wyłapywać sygnały pozostawiane przez potencjalnych samobójców i jak na nie reaguje.

Według danych policji w 2017 r. 5276 osób odebrało sobie życie, prób samobójczych, łącznie z nieudanymi, było aż 11 tys.

Zapobieganie samobójstwom na Facebooku.

Wszystko zaczyna się i kończy na ludziach. Zaniepokojeni znajomi mogą raportować posty, które budzą niepokój lub zawierają wyrażone w prost deklaracje samobójcze. Oznaczone wiadomości trafiają do moderatorów i ekspertów zajmujących się tematem samobójstw. To oni starają się określić, czy zagrożenie jest realne i jak szybko trzeba działać, żeby zapobiec potencjalnej tragedii.

Osoba, która zgłosiła posta, dostanie informacje na temat tego, jak sama może pomóc dane osobie, albo zostanie skontaktowana ze specjalistą, który jej w tym pomoże. Osoba, której post został zgłoszony, zobaczy przy najbliższym logowaniu okno z kontaktem do ekspertów, materiałami i sugestią skontaktowania się ze specjalistą albo po prostu przyjacielem. Jeśli moderator dojdzie do wniosku, że sprawa jest niecierpiąca zwłoki i komuś bezpośrednio zagraża niebezpieczeństwo, skontaktuje się z odpowiednimi służbami.

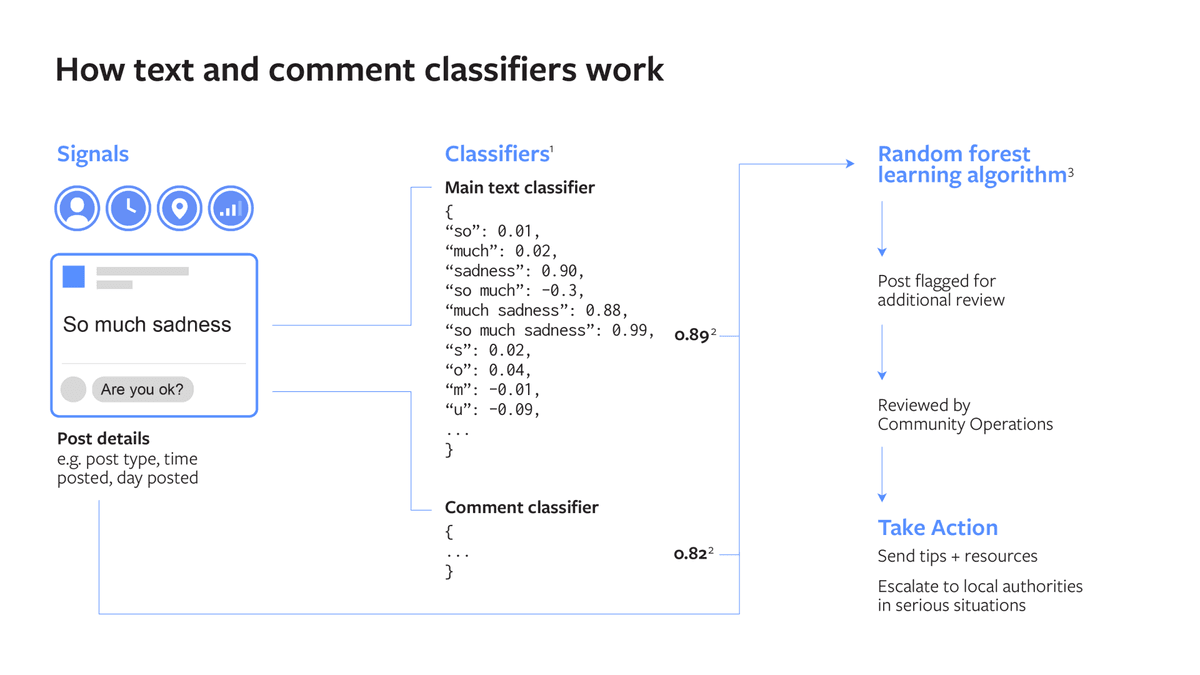

Rok temu platforma zaczęła korzystać z pomocy uczenia się maszynowego do wykrywania postów, które sygnalizują myśli samobójcze. Algorytm przeszukuje publikowane treści w poszukiwaniu określonych zwrotów w samych publikacjach, ale też w komentarzach do nich.

Facebook przyznaje, że miał duże problemy ze stworzeniem tego mechanizmu. Na początku algorytm wyłapywał frazy typu „jeśli jeszcze raz przeczytam o rasowej aferze z Ciri, to się zabiję”. Problem polegał na tym, jak nauczyć algorytm rozpoznawać, co jest werbalizacją myśli samobójczych, a co bardzo specyficznym rozwiązaniem stylistycznym. Uczenie maszynowe potrzebuje jak największej liczby przykładów, a o te w całej facebookowej puli na szczęście nie było trudno. Zmniejszono więc bazę danych. Zespół skupił się więc na postach, które zostały zgłoszone jako wyrażające myśli samobójcze i zestawił te, które zostały w toku moderacji odrzucone jako fałszywe.

Co ciekawe, oceniając, czy post zawiera myśli samobójcze, algorytm nie bierze pod uwagę tylko jego treści, ale też reakcje na nią. Jeśli znajomi oceniają, że deklaracja może być poważna, zostawiają takie komentarze jak „napisz, gdzie jesteś” czy „pamiętaj, że jestem przy tobie”. Nie bez znaczenia okazuje się też czas opublikowania wiadomości. Poranki i niedziele najwyraźniej skłaniają do poważnych myśli o śmierci.

Ponieważ analiza oparta jest na języku, algorytm nie działa w Polsce. Sami musimy być wyjątkowo czujni.

*

Jeśli masz myśli samobójcze, jest cała masa ludzi, która chce ci pomóc.

Nachodzą cię myśli samobójcze? Wydaje Ci się, że znajdujesz się w sytuacji bez wyjścia? Pamiętaj, że są osoby, które chcą i mogą Ci pomóc. Dyżurują telefonicznie lub on-line: 800 70 2222- całodobowe Centrum Wsparcia dla osób w kryzysie [WIĘCEJ INFORMACJI TUTAJ]

116 111- telefon zaufania dla dzieci i młodzieży [WIĘCEJ INFORMACJI TUTAJ]

Możesz też napisać maila lub porozmawiać na czacie. W sytuacji zagrożenia życia dzwoń pod numer 112 albo jedź na izbę przyjęć najbliższego szpitala psychiatrycznego.