Zobacz, co potrafi HDR+ na Nexusie 6

Po pojawieniu się Nexusa 6 i Androida 5.0 Lollipop, aplikacja Aparat Google doczekała się odświeżenia funkcji HDR+. Dzięki sprytnym algorytmom aparat nowego Nexusa świetni poradzi sobie zarówno nocą, jak i za dnia, w ostrym, kontrastowym słońcu. Co więcej, użytkownicy Nexusa 5 także mogą skorzystać z tych nowości.

Aplikacja do obsługi aparatu Aparat Google (poza Polską znana jako Google Camera) oferowała funkcję HDR+ już od jakiegoś czasu. Mogły z niej skorzystać tylko nieliczne smartfony, choć próby udostępnienia tej funkcji dla szerszego grona odbiorców podejmował zespół odpowiedzialny za CyanogenMod.

Po ostatnich aktualizacjach aplikacji, które odbyły się po premierze Nexusa 6, z funkcji HDR+ mogą skorzystać już wyłącznie posiadacze Nexusa 6 z Androidem 5.0 i użytkownicy Nexusa 5 z Androidem w wersji minimum 4.4. Takie ograniczenie wynika z faktu, że funkcja doczekała się nowych algorytmów, o czym pisze serwis Petapixel, jak i blog Google Research.

Na czym właściwie polega funkcja HDR? Ma ona za zadanie zmieścić na zdjęciu wszystkie poziomy jasności, których malutki aparat smartfonu nie był w stanie jednocześnie zarejestrować. Typowa sytuacja, kiedy aparat sobie nie radzi, to portret ze słońcem w tle. Możemy mieć albo dobrze naświetloną sylwetkę z zupełnie przepalonym niebem, albo czarną sylwetkę na tle niebieskiego nieba. Aby uniknąć takich sytuacji, wykorzystuje się technikę HDR.

Funkcja HDR+ w aplikacji Aparat Google przy wyzwoleniu migawki wykonuje całą serię zdjęć w trybie serii. Każde z nich jest zrobione z inną ekspozycją, a więc część jest niedoświetlona, a część celowo prześwietlona. Fotografie są następnie analizowane pod względem jasności, a algorytm składa je w jedno zdjęcie, na którym nie ma ani elementów przepalonych ani elementów zbyt ciemnych.

Kolejną sytuacją, w której przydaje się HDR+, są zdjęcia nocne, gdzie problemem jest szum. W tym wypadku algorytm również wykonuje serię zdjęć, ale składa ją nieco inaczej. Każdy piksel jest uśredniany pod względem jasności i koloru ze wszystkich zdjęć z serii, co pozwala wyeliminować odstępstwa od normy, czyli szumy.

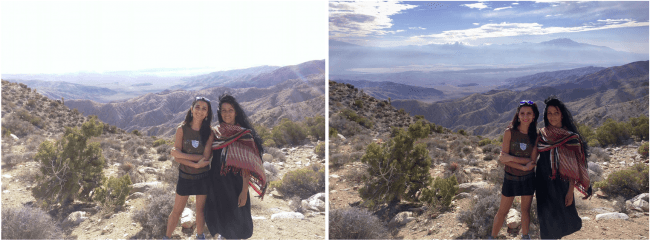

Efekty działania zaprezentowane na blogu Google robią wręcz niesamowite wrażenie. Na zdjęciu przedstawiającym portret na tle gór widać wyraźnie, jak algorytm „wyciągnął” przepalone niebo i dalsze plany. Całe zdjęcie staje się lekko plastikowe, bo dominują w nim średnie tony, ale efekt i tak jest rewelacyjny. Nie ma tu charakterystycznego, komiksowego stylu, który powstaje przy nieumiejętnym tworzeniu HDR-ów.

Z kolei zdjęcia w słabym świetle są tak dobre, że aż trudno mi uwierzyć, że są dziełem algorytmu. Nocny portret jest zupełnie odszumiony, a scena z wnętrza kościoła nie tylko straciła szumy, ale zyskała także znacznie większą szczegółowość. Efekt jest naprawdę godny podziwu.

Według Google funkcja HDR+ może być włączona na stałe i nie będzie to przeszkadzało w standardowych kadrach, które nie wymagają zwiększania rozpiętości tonalnej. Funkcję warto jednak wyłączyć przy fotografowaniu obiektów, które szybko się poruszają.

Nowe algorytmy funkcji HDR+ póki co przetestują jedynie użytkownicy Nexusów 5 i 6. Można się jednak spodziewać, że także tym razem zespół stojący za CyanogenMod prędzej czy później „uwolni” tę funkcję. Więcej przykładowych zdjęć w dużych rozdzielczościach można obejrzeć w galerii na Google+.