Google włożył sztuczną inteligencję do twojej kieszeni - tak powstała jedna z lepszych aplikacji mobilnych

Tłumacz Google, to jedna z najciekawszych i najbardziej użytecznych aplikacji od giganta z Mountain View. Początkowo był to jedynie serwis internetowy, później pojawiła się integracja z przeglądarką internetową Google Chrome, a najnowszym dzieckiem w rodzinie Google Translate jest aplikacja na urządzenia mobilne z systemami Android oraz iOS.

Oryginalnym twórcą i pomysłodawcą usługi automatycznego tłumaczenia w Google był niemiecki naukowiec informatyk Franz Josef Och. Po uzyskaniu doktoratu w Niemczech przeniósł się do Kalifornii, gdzie po okresie pracy na tamtejszym uniwersytecie został zatrudniony przez Google. W tej chwili nie pracuje już w Google, ale to on stworzył założenia do działania serwisu które do dziś są wykorzystywane.

Jedną ze znaczących decyzji jakie podjął Och było oparcie systemu tłumaczenia o analizę statystyczna, zamiast, jak większość dostępnych na rynku tego typu programów, o analizę reguł językowych. Jest to rodzaj tłumaczenia maszynowego zwany właśnie tłumaczeniem statystycznym. Ze względu na to, że jest to tłumaczenie oparte o teksty stworzone przez człowieka, daje ono bardziej naturalnie brzmiący wynik.

Innym założeniem poczynionym przez Ocha - założeniem, które jest przyczyną czasami dziwnie brzmiącego wyniku tłumaczenia - jest tłumaczenie "nie wprost". Jeżeli nie ma tłumaczenia dla danej frazy między językiem A i C, ale istnieje tłumaczenie pośrednie A -> B i B -> C, to dokonuje się takiego tłumaczenia. Zazwyczaj tym językiem "pośrednim" zostaje język angielski.

Powoduje to czasami pomyłki, lub gubi się w ten sposób część znaczeń. Dla Google'a jednak liczyła się efektywność i praktyczność tłumaczenia, dzięki któremu możemy zorientować się w znaczeniu dokumentu, ogłoszenia czy znaku drogowego.

Początkowo aplikacja mobilna była jedynie interfejsem do tekstowej usługi online. Z czasem zaczęła zyskiwać nową funkcjonalność, taką jak możliwość dyktowania zdań do tłumaczenia oraz tłumaczenia ze zdjęć. To właśnie ta funkcja zaczęła nabierać kolorów po tym, jak w 2014 roku Google nabyło firmę Quest Visual, twórcę aplikacji World Lens. Od tego czasu funkcje rozpoznawania obrazu stawały się coraz bardziej rozbudowywane.

Najnowsza aktualizacja aplikacji Google Translate przynosi małą rewolucję, której efektów jednak nie widać na pierwszy rzut oka. Umożliwia ona (ograniczone) tłumaczenie offline, jak również lepsze rozpoznawanie tekstu bez pośrednictwa serwera. Jak to możliwe?

Barak Turovsky, jeden z inżynierów Google, napisał na oficjalnym firmowym blogu wpis, ujawniający kilka szczegółów na temat nowej wersji.

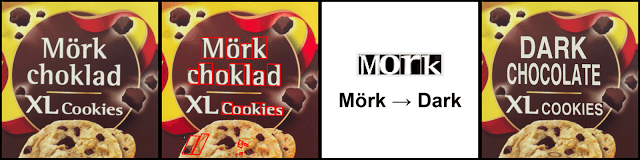

Po pierwsze, obsługuje ona już 27 języków w opcji "tłumaczenia wizualnego". Polega ono na wskazaniu obiektywem wbudowanego w urządzenie aparatu znaku lub komunikatu w obcym języku, a aplikacja dokona tłumaczenia, a następnie wklei je w miejsce oryginału. Jest to funkcjonalność oparta na funkcjach otrzymanych przy zakupie firmy Quest Visual. Aby umożliwić działanie większej liczbie funkcji bez połączenia sieciowego bez efektu zwiększenia objętości pobieranej aplikacji, użytkownik pobiera jedynie małe (około 2-5 MB) pakiety językowe dla języków, które go interesują.

Druga nowość nie jest widoczna na pierwszy rzut oka, ale jest najciekawszą nowinką. Na naszym telefonie zaczęła działać mała, specjalnie wytrenowana sieć neuronowa. Ta kieszonkowa sieć przejęła część funkcji dotychczas zarezerwowanych dla serwera.

Jak wyjaśnia inny inżynier Google, Otavio Good, kluczem do stworzenia małej i wydajnej sieci neuronowej, która będzie działać na urządzeniach mobilnych było odpowiednie dobranie danych treningowych. Good wyjaśnia również, krok po kroku, jak działa rozpoznawanie i tłumaczenie obrazów w aplikacji.

Pierwszym etapem jest rozpoznanie liter w obrazie. Robi to poszukując na obrazie pikseli o podobnym kolorze, zebranych w grupy, które (idealnie) układałyby się w linie tekstu.

Drugi krok polega na rozpoznaniu liter (OCR - optical character recognition). Tutaj działa sieć neuronowa wytrenowana w rozpoznawaniu liter - nawet jeśli są niewyraźne, obrócone lub stylizowane.

Trzecim krokiem jest poszukiwanie "przybliżonych" słów w słownikach. Na czym polega przybliżenie? Jeśli rozpoznaliśmy literę S jako 5, to wciąż będziemy w stanie rozpoznać 5top jako Stop.

Ostatni krok to zastąpienie istniejących liter na obrazie. Jest to najbardziej efektowne, jednak według Gooda nie jest to wcale trudne - przecież mamy już "alfabet" złożony z rozpoznanych czcionek, wystarczy z nich ułożyć słowa w odpowiednim miejscu.

Jak oceniają inżynierowie z Google, osiągnięto w ten sposób o wiele lepsze (statystycznie poprawniejsze) wyniki tłumaczenia, mieszcząc się w dotychczasowych ramach czasowych.

Nie myślimy o tym, korzystając z naszych Samsungów, iPhone'ów czy Lumii, ale są to potężne urządzenia, których kilka lat temu nie powstydzilibyśmy się na biurkach. Potrafią mieć gigabajty pamięci i wielordzeniowe procesory. Teraz zaczynają nam na nich pomagać zaczątki sztucznej inteligencji - bo tym właśnie są trenowane sieci neuronowe.

Szkoda tylko, że tak mało ludzi zdaje sobie sprawę z tego, co nosi w kieszeni.

* Grafika główna pochodzi z Shutterstock.