Od 45 lat skupiają się wyłącznie na układach scalonych - historia AMD

Wiele firm zajmujących się elektroniką użytkową istnieje na rynku od dekad. Jednak bardzo niewiele z nich od początku szlifuje swoje umiejętności w jednej, konkretnej dziedzinie. AMD w 1969 roku już wiedział, że chce być liderem w branży zajmującej się układami scalonymi.

Firma Advanced Micro Devices (w skrócie: AMD) nie jest tak młoda, jak niektórym mogłoby się wydawać. Została bowiem założona już pierwszego maja 1969 roku przez grupę byłych dyrektorów Fairchild Semiconductor, a więc przez osoby mające już doświadczenie w produkcji półprzewodników. W grupie założycieli znaleźli się Jerry Sanders III, Ed Turney, John Carey, Sven Simonsen, Jack Gifford i jego trzech podwładnych: Frank Botte, Jim Giles i Larry Stenger.

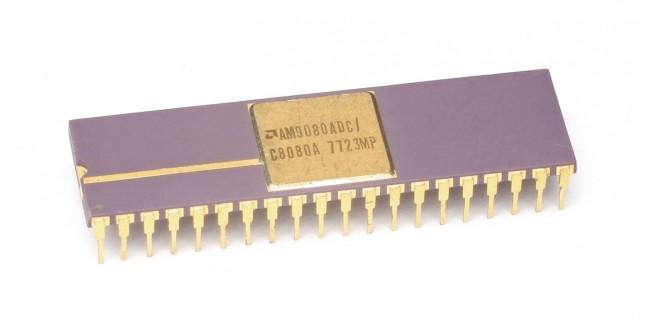

Cel był jasny: wykorzystać zdobyte doświadczenie i podbić świat rynku mikroprocesorów. Panowie niezwłocznie usiedli do desek kreślarskich i biznesplanów i rozpoczęła budowę swoich pierwszych układów logicznych. Firmie szło na tyle dobrze, że szybko postanowiła poszerzyć swoje portfolio. Już w 1975 roku zaczęła produkować pamięci RAM oraz udało jej się… stworzyć klon procesora Intel 8080. AMD nie dysponowało odpowiednią dokumentacją, a jego konkurent, z oczywistych względów, nie chciał jej udostępnić. Inżynierowie AMD zdołali jednak rozgryźć jego architekturę za pomocą inżynierii wstecznej, a działania te były finansowe dzięki odnoszącym na rynku coraz większy sukces procesorom typu bit-slice.

AMD nie planowało jednak oprzeć swojej działalności na tworzeniu tańszych odpowiedników mikroprocesora konkurencji i zaczęło szukać swojej własnej tożsamości. Popełniło przy tym kilka błędów. Jednym z nich jest chociażby wiara w przyjęcie się architektury RISC. AMD stworzył nawet pod koniec lat siedemdziesiątych RISC-owy procesor AMD Am29k, o którym dziś już niewiele osób pamięta. Firma też delikatnie badała rynek urządzeń multimedialnych i pamięci EPROM, ale jedynym wartym odnotowania jej sukcesem był… modem FSK. Urządzenie stało się bardzo popularne z uwagi na to, że działało na całym świecie. Wbudowany w ów modem układ obsługiwał wszystkie standardy telefoniczne, zarówno bellowski jak i CCITT. Niestety, poza nim… sukcesów większych brak.

Wygrała architektura x86

AMD, chcąc nie chcąc, musiało wrócić do roli producenta klonów układów Intela i pamięci flash. Zarząd jednak wiedział, że samo to nie wystarczy, by odnieść sukces. Ciężko bowiem podbić rynek będąc o krok za konkurencją. Postawiono więc na gromadzenie kapitału „a potem się zobaczy”. Układy x86 firmy AMD kusiły więc partnerów i nabywców atrakcyjnymi cenami, a sama firma liczyła na to, że zdobędzie swoje miliony przez masową sprzedaż (względnie) tanich procesorów.

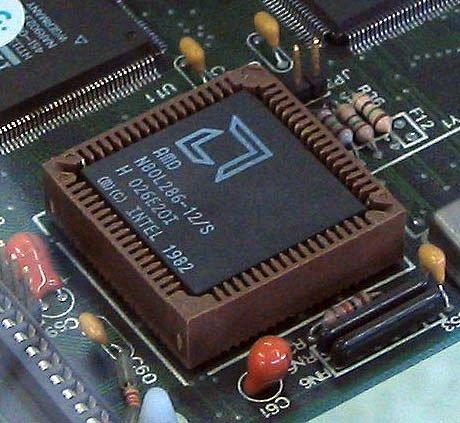

W lutym 1982 roku AMD podpisał oficjalną umowę z Intelem, stając się certyfikowanym producentem procesorów 8086 i 8088. Nie była to przyjaźń z wyboru: procesory Intela lądowały przede wszystkim w komputerach IBM, a ta firma prowadziła sztywną i niezłomną politykę: wymagała, by istniało co najmniej dwóch, niezależnych dostawców układów scalonych. AMD ze swoimi procesorami Am286 był oczywistym wyborem.

Intel z czasem pożałował tej decyzji: klony komputerów IBM PC z „podróbkami” procesorów Intela zaczęły zalewać rynek. Intel, w samoobronie, utajnił specyfikację techniczną modułu i386. AMD jednak uznał, że to naruszenie dotychczasowej umowy między tymi dwiema firmami i pozwał Intela. Skutecznie. Intel musiał nadal udostępniać partnerowi niezbędne dane. AMD jednak, na wszelki wypadek, zaczął opracowywać swoje własne mikroprogramy dla swoich procesorów metodą cleanroom.

W efekcie w 1991 roku pojawiły się układy Am386 (klon 386), które sprzedały się w ilości jednego miliona egzemplarzy… przez rok. Jego następca, Am486 znalazł się w komputerach Compaq, a Am5x86 podbił rynek dzięki bardzo atrakcyjnej cenie. Rynek jednak przyspieszał a AMD praktycznie przestał się rozwijać, skupiając się na powtarzaniu innowacji wprowadzonych przez konkurentów.

Pora na autorskie konstrukcje

Pierwszy procesor zaprojektowany całkowicie od zera przez AMD pojawił się w roku 1996 i nazywał się K5. Litera „K” w nazwie oznaczała… kryptonit, a więc jedyną substancję mogącą skrzywdzić Supermena. Aluzja do hegemonii Intela na rynku i „wyzwoliciela” w postaci AMD była dość wyraźna. Piątka z kolei oznaczała piątą generację układów o architekturze x86: nazwa Pentium została bowiem zastrzeżona przez Intela.

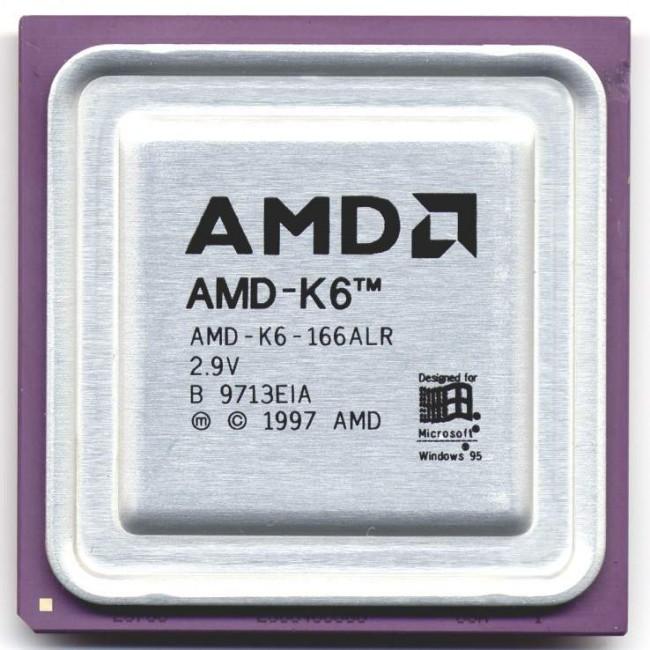

AMD nie spoczęło na laurach. W tym samym roku zakupiło firmę NexGen zajmującą się procesorami Nx. Wykorzystał ich wiedzę i kreatywność by stworzyć procesor K6, który pojawił się w 1997 roku. Był to szybszy i tańszy procesor od intelowskiego Pentium II. A to był dopiero początek ofensywy. Kolejny rok to kolejna seria procesorów: K7, rozdzielona na dwie rodziny: wydajne Athlony i tanie Durony. Po raz pierwszy zastosowano własne złącza do procesorów, gdyż Intel zastrzegł sobie prawo do swojego standardu Slot 1, chcąc bronić się przed swoim wielkim konkurentem. AMD przekonał więc producentów płyt głównych do stworzenia platform ze złączem Socket A. Producenci tych urządzeń nie próbowali się nawet przed tym bronić, co było poważnym ciosem dla pewnego siebie Intela.

64 bity i wielordzeniowość dla mas… od AMD

AMD nie tylko dogoniło, ale i przegoniło Intela jeżeli chodzi o tempo wprowadzania innowacji na rynek. Dowodem na to jest rodzina procesorów K8, a więc pierwsze konsumenckie układy CPU o 64-bitowej architekturze x86-64. Jakby tego było mało, procesory te posiadały kolejne innowacje, takie jak wbudowany w procesor kontroler pamięci i moduł HyperTransport znacznie zwiększający wydajność procesora w specyficznych rodzajach przeliczeń. Procesory Athlon 64 miażdżyły konkurencję, a i serwerowe Opetrony zaczęły zdobywać uznanie.

To był jednak dopiero początek. 2005 roku pojawiły się pierwsze dwurdzeniowe procesory Opetron, a także pierwsze dwurdzeniowe procesory dla użytkowników końcowych, co musiało doprowadzić Intela do szewskiej pasji. AMD z jego Athlonami 64 X2 znowu wyszedł przed szereg, po raz kolejny pokazując, że to on tu jest głównym innowatorem, a nie Intel.

A może by tak podbić kolejny rynek?

Dopiero w połowie 2006 roku AMD wróciło do swoich ambitnych planów na rozwój. Chcąc przegonić konkurencję wybrał drogę nieco na skróty i w tymże roku przejął jednego z największych producentów kart graficznych na świecie: firmę Ati, największego rywala Nvidii. AMD zapłaciło za to 5,4 miliarda dolarów, ale zaoszczędziło jeszcze większe pieniądze na budowaniu własnego know-how. Nvidia nagle zyskała dużo groźniejszego rywala, który, w przeciwieństwie do niej, zajmuje się nie tylko układami GPU, ale i również CPU. Jak wiemy wszyscy, twórcy GeForce’ów przetrwali (i radzą sobie bardzo dobrze), ale AMD stał się na tyle potężny, że reszta firm nie miała już żadnych szans. Nikt już nie pamiętał liderów innowacji takich, jak 3dfx czy Matrox. Zostali zepchnięci na margines lub kupieni, a duopol AMD i Nvidii trwa po dziś dzień.

AMD nie zaniedbał jednak rynku CPU i w 2007 roku pojawiły się trzy- i czterordzeniowe procesory K10. Wykorzystywano coraz nowocześniejsze procesy technologiczne, dochodząc przy okazji układów Phenom w 2009 roku do 45-nanometrowego. AMD zaczął kombinować… co dalej? Pierwsze oznaki nadciągającej rewolucji symbolizowała platforma Spider, która łączyła układy Phenom z układami graficznymi Ati R770 i chipsetem 790 GX/FX. Nikt jednak nie zwracał na to uwagi, bo „coś” się w układach AMD popsuło. Dalej były tańsze od intelowskich odpowiedników, ale mimo wdrożonych w nie innowacji, były… wolniejsze. I to zauważalnie. W segmencie układów z niskiej i średniej półki cenowej dalej były ciekawą i atrakcyjną alternatywą, ale Intel zaczął rządzić w segmencie najwydajniejszych układów.

AMD bowiem cały czas rozwijał swoją architekturę K8. To mu pozwoliło na osiąganie coraz niższych cen swoich procesorów, w tym najwydajniejszych. Wszystko dzięki znajomości procesu technologicznego i możliwości jego optymalizacji. Każda architektura ma jednak swoje limity. Intel wprowadził na rynek procesory Core, które co prawda były nieco droższe od procesorów od AMD, ale zauważalnie wydajniejsze o nowocześniejszej architekturze. Nie zmieniły tego nawet sześciordzeniowe (sic!) procesory „Thuban” z rodziny Phenom II.

AMD nie zapomniał jednak o Spiderze. I to stanowiło jego największy as w rękawie.

A gdyby tak połączyć siły CPU i GPU?

AMD, mimo iż zaczął dostawać po nosie od Intela, nadal był jednym z liderów rynku CPU. Był też, obok Nvidii, liderem rynku GPU. I jako jedyny w branży dysponował oboma tymi zasobami. Nadszedł czas, by to wykorzystać. Tak powstał projekt „Fusion”, zakładający przeniesienie części przeliczeń (a konkretniej: przeliczenia zmiennoprzecinkowe) z układu CPU do układu GPU.

Pierwszym zauważalnym efektem tej synergii były układy Llano oparte o architekturę Phenom II „Deneb”. Kolejnym krokiem był zaprojektowany zupełnie od nowa układ, który miał zmiażdżyć konkurencję niczym buldożer drzewa przeznaczone do wycinki. Nie zmiażdżył, nawet nie był temu bliski, ale „Bulldozer” dał jej dużo do myślenia. Innowacyjny pomysł na nowy rodzaj układu scalonego zwrócił uwagę wielu osób, mimo iż same układy… nie oferowały znaczącej przewagi nad wydajnością procesorów z rodziny K10, że o konkurencji nie wspomnimy. Miał on jednak osiem rdzeni a zarazem nie wymagał dużej ilości energii. I tak jak był sygnałem nadchodzących zmian, tak zarazem był zmarnowanym potencjałem. By móc wykorzystać tak dużą ilość rdzeni, oprogramowanie musiało „potrafić” wykorzystać dostępną wielowątkowość. AMD zaniedbał (delikatnie rzecz ujmując) współpracę z partnerami i oprogramowania potrafiącego wycisnąć ostatnie soki z ośmiordzeniowców było jak na lekarstwo. Dziś ta sytuacja wygląda zupełnie inaczej: oprogramowanie Microsoftu, Adobe, Sony i wielu innych jest w stanie zrobić dobry użytek z wielordzeniowych układów, ale w tamtym kluczowym okresie… niestety, mało kto zajmował się pisaniem wielowątkowego oprogramowania.

Układ ten stał się jednak podstawą do stworzenia pierwszego APU (Accelerated Processing Unit), a więc 64-bitowego procesora i układu graficznego w jednym układzie scalonym. Llano posiadał CPU K10 i GPU Radeon HD 6000. Do niego dołączyły energooszczędne układy Brazos, które łączyły procesory o architekturze Bobcat i ten sam układ graficzny. Wtedy też AMD zaczął promować pojęcie HSA a więc heterogeniczną architekturę systemów, tym samym promując ideę równoległego przetwarzania danych przez CPU i GPU, wyciągając wnioski z poprzednich porażek.

Kolejna generacja APU była zauważalnym usprawnieniem wobec poprzednich. Generacja „Trinity” była wyposażona w rdzenie Pilediver oraz układy graficzne Radeon HD 7000, a całość wykorzystywała gniazdo FM2. Doczekała się ona drobnych usprawnień w postaci „Richland” i „Brazos 2.0”, a trzecia generacja, czyli „Kaveri” dla desktopów i laptopów oraz energooszczędne „Kabini” i „Temash” (wraz ze swoimi następcami, a więc „Beema” i „Mullins”) mogą się pochwalić jeszcze głębszą i ściślejszą integracją modułów CPU i GPU.

Upływ czasu jest nieubłagany

Rewolucje nie odbywają się jednak bez ofiar. W czasie gdy AMD zmieniał swoje podejście do tworzenia układów scalonych i szukał swojej własnej drogi, konkurencja w postaci Intela i Nvidii nie próżnowała. Pod koniec 2011 roku AMD ogłosiło, że jest zmuszony zwolnić 10 procent swojej globalnej siły roboczej. Rok później pożegnano się z kolejnymi 15 procentami. Powód? Spadająca sprzedaż a wraz z nią przychody.

To nie był jednak akt desperacji. AMD doskonale rozumiał w jak wrażliwej i zagrożonej pozycji obecnie się znajduje, mimo iż był dalej w czołówce. Określenie „drugie miejsce na rynku” może być jednak mylące. Gdy Intel dał rynkową plamę i walczył ze swoją niedoskonałą architekturą Netburst za czasów układów Pentium IV, jego udziały rynkowe spadały nieznacznie. AMD groziły znacznie poważniejsze konsekwencje.

Zwolnienia wiązały się jednak nie z chęcią zwinięcia części interesów, a z restrukturyzacją. AMD nie zamierzał się poddawać i miał wizję wyjścia z kryzysu, w którym się znalazł. Przebudował znaczną część swojego cyklu technologiczno-logistycznego, dokonał istotnych zmian w zarządzie a także zaczął intensywniej rozwijać inne działy, które nie mają dużego wizerunkowego znaczenia, ale za to zapewniają stały dopływ gotówki. Mowa tu nie o układach typowo konsumenckich, ale również rozwiązaniach wbudowanych, układach graficznych FirePro dla profesjonalistów a także GPU przeznaczonych dla najbardziej wymagających graczy.

Efekty tych działań zdecydowanie widać. Na mówienie o całkowitym zażegnaniu kryzysu jest zdecydowanie za wcześnie. Ale AMD rywalizuje obecnie zarówno z Nvidią jak i Intelem i radzi sobie na tym polu bardzo dobrze. Do zyskania przewagi rynkowej czy kapitałowej nad którymkolwiek z konkurentów jeszcze droga daleka. Patrząc jednak na historię tej firmy, stawiam dolary przeciwko orzechom, że nie tylko prędko z rynku nie zniknie, ale dzięki swoim układom APU i nowym pomysłom na ekspansję na inne rynki (jak chociażby rynek procesorów ARM) będzie nadal radzić sobie co najmniej wybornie…

„Everybody loves an underdog”

To znane powiedzenie wśród marketerów zajmujących się promocją celebrytów. Ludzie zazwyczaj dużo większą sympatią darzą Dawida od Goliata, a AMD może być postrzegany w podobny sposób. Oto bowiem pojawia się świeży gracz, który oferuje innowacyjne rozwiązania budzące z letargu tytanów w postaci Nvidii i Intela. To jednak nie jest najszczęśliwiej dobrana analogia i wręcz krzywdząca dla tej firmy.

AMD bowiem może i faktycznie nie jest takim molochem, jak firmy którym rzuca wyzwanie. Rzeczywiście zaczął też budować swój sukces w sposób iście garażowy, przerabiając cudze konstrukcje na tańsze i przystępniejsze dla Kowalskiego. Patrząc na to w ten sposób zapominamy jednak o unikalnych innowacjach, jakie ta firma wprowadziła na rynek.

Modem działający na całym świecie z początków istnienia firmy AMD to ciekawa innowacja, ale blednie przy kolejnych. Firma ta wprowadziła pod strzechy procesor taktowany z częstotliwością 1 GHz już w 2000 roku. „Kowalscy” uzyskali pierwsze wielordzeniowe procesory raptem cztery lata później (i mowa tu o fizycznych, a nie tylko logicznych rdzeniach). Dwie najważniejsze konsole do gier na rynku wykorzystują obecnie układy scalone APU od firmy AMD, a deweloperzy piszący gry i aplikacje na komputery PC mogą skorzystać z nowatorskiego API o nazwie Mantle, które zapewnia znacznie większą kontrolę nad sprzętem od DirectX, pozwalając na „wyciśnięcie” znacznie więcej z karty graficznej, niż w przypadku wykorzystania konkurencyjnych API.

Dodatkowo, ciężko AMD kojarzyć z „piratami” Doliny Krzemowej. Firma ta przechodziła już przez niejeden kryzys i właściwie nawet w tym momencie kończy wychodzenie z kolejnego. Potrafi jednak zręcznie i sprawnie wyciągać wnioski ze swoich potknięć. Kapitał jaki gromadzi dzięki rozwiązaniom dla profesjonalistów, dzięki ekspansji na rynek przemysłowy już teraz pozwala na coraz większe inwestycje na tym rynku, który nas ciekawi najbardziej: na rynku konsumenckim, gdzie innowacje w układach scalonych są szczególnie widoczne. I pożądane.

Dawid był mniejszy od Goliata, ale nikt ma prawa go nazywać ofiarą

A skoro już o innowacjach mowa, warto przypomnieć sobie jeszcze jeden aspekt historii AMD, który faktycznie pozwala tej firmie kojarzyć się ze wspomnianym w poprzednim nagłówku underdogiem. Skupienie się wyłącznie na układach scalonych pozwala na szybkie wprowadzanie innowacji… w teorii. Niestety, praktyka bywa bezlitosna. AMD konkuruje z „molochami”, którzy operują w dziesiątkach innych branż dysponując dzięki temu gigantycznymi kapitałami. To rynek, który jest tak wielki i potężny, że zahacza o… międzynarodową politykę.

Przypomnijmy sobie chociażby niedawną wpadkę największego konkurenta AMD, który w wyniku „wykrycia” musiał schudnąć w 2008 roku o 1,06 miliarda euro za udowodnienie mu praktyk monopolistycznych. Ów konkurent stosował na terenie Unii Europejskiej praktyki mające zablokować sprzedaż procesorów firmy AMD udzielając nielegalnych rabatów na swoje układy takim firmom, jak Lenovo, HP, Acer czy Dell. Rabat się zwiększał, jeżeli owi partnerzy, dodatkowo, „opóźniali premiery” komputerów z procesorami AMD.

Unia Europejska jest tu tylko przykładem. Na japońskim i amerykańskim rynku konkurencja również ma swoje za uszami i nieraz już jej to udowodniono przed odpowiednimi instytucjami. Moloch może wprowadzać innowacje, bo go na to stać. Może też wstrzymać ich wprowadzanie wykorzystując swoją pozycję na rynku. Mniejsza, bardziej wyspecjalizowana firma, taka jak AMD, ma dynamiczniejszą strukturę wewnętrzną, co pozwala jej szybciej zamieniać projekty w rzeczywistość. Wprowadzanie jednak nowości na rynek, które mają zmienić jego kształt, to w przypadku AMD działanie co najmniej ryzykowne. Konkurent, mimo iż znacznie bardziej ospały, ma „inne środki” do zablokowania underdoga. Czego dowodzi chociażby powyższy przykład krzywdzącego porozumienia pomiędzy konkurencją AMD a jej partnerami OEM.

Quo vadis, AMD?

Jak potoczy się dalsza historia tej firmy? To trudno stwierdzić. Nie tylko z uwagi na to, że rynek elektroniki użytkowej rozwija się w sposób nieprzewidywalny, ale również dlatego, że AMD na chwilę obecną ma przed sobą olbrzymie możliwości. Jest absolutnym liderem na rynku układów APU. Rozwija zarówno konsumenckie GPU Radeon, jak i profesjonalne FirePro. Posiada licencje zarówno na architekturę ARM jak i x86. Nie wiem co dzień jutrzejszy oznacza dla AMD. Ale intuicja podpowiada mi, że będzie on bardzo interesujący.

Bez Ati nie byłoby AMD w obecnej formie

Ati jest taką samą częścią AMD, jak… AMD częścią Ati. Przejęcie tej firmy nie odbyło się na typowych zasadach. Bardziej tu pasuje określenie „fuzja”. AMD bowiem, po kupnie Ati, to zupełnie nowa firma, na którą składają się „stare AMD” i Ati. Układy Radeon i FirePro są nadal oczkiem w głowie AMD i można się spodziewać, że to w przewidywalnej przyszłości się nie zmieni.

Ati została założona w 1985 roku przez Lee Ka Lau, Francisa Lau, Benny’ego Lau i Kwok Yuen Ho. Firma ta nie miała ambitnych początków, ale bardzo szybko się rozwijała jako partner OEM takich producentów, jak IBM i Commodore. Jednak w 1987 roku firma ta zaprezentowała swoje pierwsze produkty autorskiej konstrukcji: były to układy graficzne EGA Wonder i VGA Wonder. Na pierwsze ciekawe konstrukcje musieliśmy poczekać jednak do lat dziewięćdziesiątych.

Wtedy to bowiem Ati zaprezentował swój pierwszy akcelerator graficzny, a więc GPU potrafiące przetwarzać elementy graficzne bez obciążania procesorów CPU. Dzięki tym kartom (Mach8 i Mach 32) Ati wchodzi na giełdę papierów wartościowych i zaczyna być zauważany przez resztę rynku.

Firma poszła za ciosem i zaczęła wprowadzać kolejne innowacje. Akcelerator Mach64 był jednym z pierwszych, które w podstawowy sposób akcelerowały przetwarzanie i obróbkę multimediów (a w szczególności wideo) a karty z serii Rage, które łączyły tradycyjne układy graficzne z akceleratorami 3D były pierwszą rozsądną alternatywą wobec królujących na rynku 3dfx Voodoo. Rage też jako jedne z pierwszych były zgodne z DirectX 6.0 API.

Ati lubował się w łączeniu technologii w układach graficznych. Po karcie, która pełniła rolę zarówno karty graficznej, jak i akceleratora 3D, nadszedł czas na takie produkty, jak urządzenia All-in-Wonder, łączące 64-bitowe układy przetwarzania grafiki 2D, akcelerator 3D Rage II oraz… tuner telewizyjny i akcelerator danych wideo. W 1996 roku Ati opracował też swoje pierwsze akceleratory 3D dla laptopów (jedne z pierwszych na rynku) i zaczął… kupować słabszych konkurentów, przejmując Tseng Labs i ArtX.

Rok 2000 to ostatni ważny rozdział w historii Ati zanim ta została przejęta przez AMD. Wtedy bowiem zaprezentowano układy graficzne Radeon, zgodne z rewolucyjnym jak na tamte czasy DirectX 7 API. To były urządzenia najwyższej klasy, dostępne dla wszystkich półek cenowych. To z kolei zwróciło uwagę Microsoftu, który zlecił Ati zaprojektowanie układu graficznego dla następcy konsoli Xbox (a później, o czym już zapewne wiecie, również dla następcy konsoli Xbox 360).

Ati była jedyną firmą, która była w stanie konkurować z podbijającą świat Nvidią. Teraz, będąc częścią AMD, jest (obok Nvidii) najważniejszym producentem układów graficznych na świecie.

-

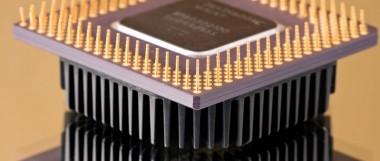

Zdjęcie tytułowe pochodzi z serwisu Shutterstock